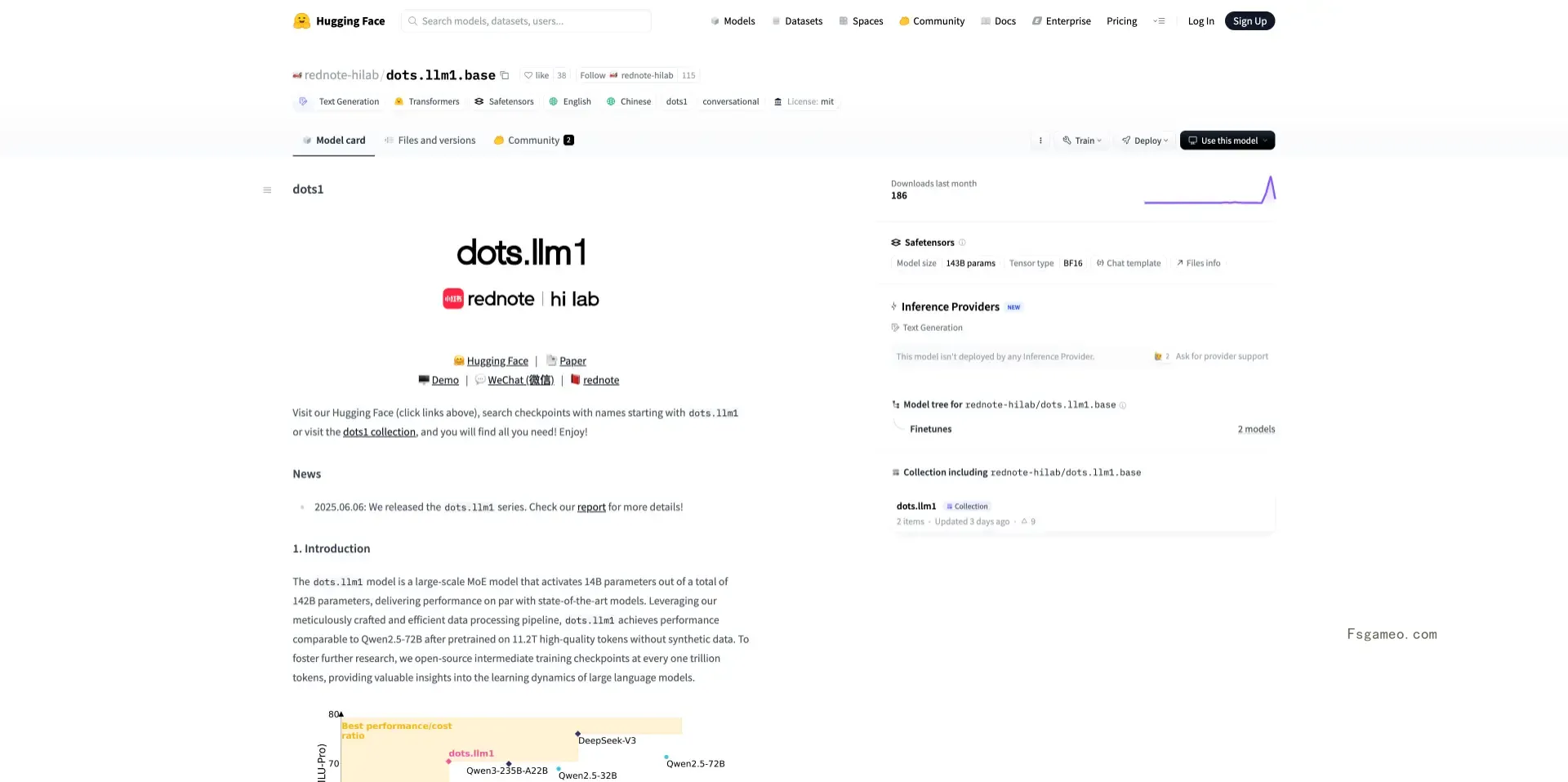

dots.llm1是什么?

dots.llm1 是小红书开源的一种采用 MoE(混合专家)架构的大语言处理模型,它拥有高达 1420 亿的参数,但在推理过程中仅激活其中的 140 亿,从而在保证性能的同时也提升了效率。该模型基于 11.2 万亿条非合成的高质量数据训练而成,不仅支持中英文双语处理,还具备处理长达 32K 字符上下文的能力。

此外,dots.llm1 开放了其中间的训练检查点,这使其非常适合应用于问答系统、内容自动生成、语义理解等多个领域。在中文基准测试中,dots.llm1 在包括 MMLU、CMMLU、CEval 等多项综合评测中得分均超过了 DeepSeek V2/V3 以及阿里 Qwen2.5-32B/72B 等主流开源模型,充分展示了其在中文理解和生成任务上的强大竞争力。

dots.llm1 的模型亮点

- 模型以稀疏激活和高效率架构为特色,总参数量达到1420亿,但在每次推理过程中仅激活140亿参数,凭借MoE架构,实现了计算性能和推理效率的完美平衡。在预训练阶段,我们使用了高达11.2万亿的非合成高质量token数据进行训练,完全摒弃了人工合成数据,使得内容更加自然和真实。

- 在工程优化方面,我们采用了前沿的all-to-all通信与计算重叠技术,基于1F1B流水线与Grouped GEMM技术,显著提升了大模型的部署效率。数据处理能力方面,模型内置了三级高精度数据清洗流程,能够生成多样性强、质量高的预训练语料,同时支持中英文双语处理。

- 该模型的上下文窗口长度可达32K tokens,能够处理更长的文本,非常适合长文生成和复杂的推理任务。为了促进研究,我们每训练1万亿token便会开源一次checkpoint,让研究者可以深入了解大模型的学习动态。

- 模型原生支持中文和英文,展现出跨语种的语义适应能力。我们采用MIT许可证,既方便学术研究,也利于商业应用。

dots.llm1 的应用场景

- 智能问答系统能够构建多轮对话型助手与知识问答平台,非常适用于客服、电商以及教育等多种场景。

- 自动摘要生成技术可以为资讯、法律、医疗等领域的文档快速提炼出核心内容,从而显著提升信息处理效率。

- 内容创作与编辑协同功能可以生成社交媒体文案、营销文本、脚本等,非常适合内容创作者与品牌方使用。

- 搜索增强与语义检索技术能够改善搜索的精准度与个性化体验,尤其适用于电商平台和知识库等系统。

- AI辅助写作与翻译在教育、出版、商业写作中提供语言润色、多语翻译与写作建议。

- 企业知识管理与问答系统则助力企业构建内部文档智能检索与员工问答系统,大幅提升运营效率。

- 教学与学术研究辅助功能可用于智能出题、答题、模型分析等,为教育产品和科研探索提供有力支持。